Los científicos enseñaron a una red neuronal artificial a imitar una neurona biológica. El resultado ofrece una nueva forma de pensar sobre la complejidad de las células cerebrales y muestra la complejidad computacional de una neurona.

Nuestro cerebro y la complejidad computacional de una neurona

Nuestro tupido cerebro parecen estar muy lejos de los chips de silicio sólido utilizados en los procesadores de ordenadores. Pero los científicos tienen una larga historia de comparar ambos. Como dijo Alan Turing en 1952: «No nos interesa el hecho de que el cerebro tenga la consistencia de una papilla fría». En otras palabras, no importa el medio, solo la capacidad computacional.

Hoy en día, los sistemas de inteligencia artificial más poderosos emplean un tipo de aprendizaje automático llamado aprendizaje profundo (Deep Learning). Sus algoritmos aprenden procesando cantidades masivas de datos a través de capas ocultas de nodos interconectados. Estas son conocidas como redes neuronales profundas. Como sugiere su nombre, las redes neuronales profundas se inspiraron en las redes neuronales reales del cerebro. Están dotadas de nodos modelados a partir de neuronas reales. O al menos, a partir de lo que los neurocientíficos sabían sobre las neuronas en la década de 1950. Para entonces nació un influyente modelo de neuronas llamado «el perceptrón». Desde entonces, nuestra comprensión de la complejidad computacional de las neuronas individuales se ha expandido drásticamente. Por lo que se sabe que las neuronas biológicas son más complejas que las artificiales. ¿Pero cuánto más complejas son?

Estudio

Para averiguarlo, David Beniaguev, Idan Segev y Michael London, todos en la Universidad Hebrea de Jerusalén, entrenaron una red neuronal profunda artificial. La finalidad era imitar los cálculos de una neurona biológica simulada. Demostraron que una red neuronal profunda requiere entre cinco y ocho capas de «neuronas» interconectadas para representar la complejidad de una sola neurona biológica.

Incluso los autores no anticiparon tal complejidad. «Pensé que sería más simple y más pequeño», dijo Beniaguev. Esperaba que tres o cuatro capas fueran suficientes para capturar los cálculos realizados dentro de la celda.

Timothy Lillicrap, (diseñador de algoritmos de toma de decisiones en la empresa de inteligencia artificial DeepMind, propiedad de Google) dijo; «El nuevo resultado sugiere que no se puede comparar libremente una neurona en el cerebro con una neurona en el contexto del Machine Learning». Insistió en que «Este documento realmente ayuda a forzar el tema de pensar en eso con más cuidado. De este modo lidiar con hasta qué punto se pueden hacer esas analogías».

Analogía de la complejidad computacional de una neurona

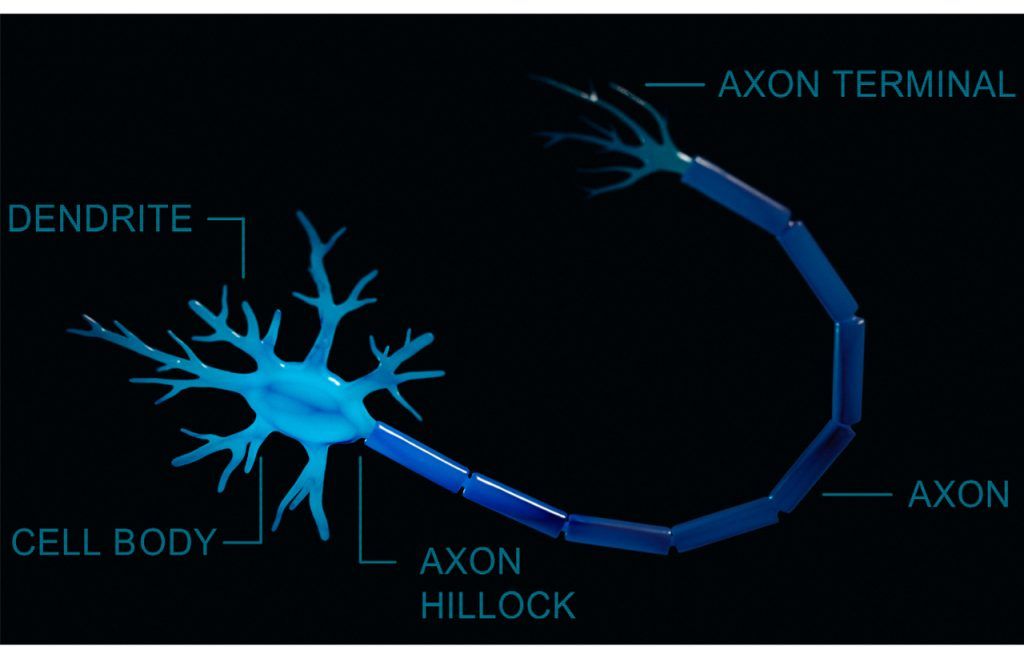

La analogía más básica entre neuronas artificiales y reales implica cómo manejan la información entrante. Ambos tipos de neuronas reciben señales de entrada y, basándose en esa información, deciden si envían su propia señal a otras neuronas. Si bien las neuronas artificiales se basan en un cálculo simple para tomar esta decisión en las biológicas es distinto. Décadas de investigación han demostrado que el proceso es mucho más complicado. Los neurocientíficos computacionales utilizan una función de entrada-salida. Su finalidad es modelar la relación entre las entradas recibidas por las ramas largas en forma de árbol de una neurona biológica (Dendritas). Para finalmente provocar la decisión de la neurona de enviar una señal.

Esta función es la que los autores del nuevo trabajo le enseñaron a imitar a una red neuronal profunda artificial para determinar su complejidad. Comenzaron creando una simulación masiva de la función de entrada-salida. Exactamente de un tipo de neurona con distintos árboles de ramas dendríticas en su parte superior e inferior. Esta se conoce como neurona piramidal, de la corteza de una rata. Posteriormente, introdujeron la simulación en una red neuronal profunda que tenía hasta 256 neuronas artificiales en cada capa.

Continuaron aumentando el número de capas hasta que lograron una gran precisión. Un resultado del 99% en el nivel de milisegundos entre la entrada y la salida de la neurona simulada. La red neuronal profunda predijo con éxito el comportamiento de la función. Esta entrada-salida de la neurona se realizó con un mínimo de cinco y un máximo de ocho capas artificiales. En la mayoría de las redes, eso equivalía a unas 1.000 neuronas artificiales para una sola neurona biológica.

El resultado

Forma un puente entre las neuronas biológicas y las neuronas artificiales”, dijo Andreas Tolias, neurocientífico computacional de Baylor College of Medicine.

Pero los autores del estudio advierten que aún no se trata de una correspondencia sencilla. «La relación entre cuántas capas tiene en una red neuronal y la complejidad de la red no es obvia», dijo London. Por lo tanto, realmente no podemos decir cuánta más complejidad se gana al pasar, por ejemplo, de cuatro capas a cinco. Tampoco podemos decir que la necesidad de 1.000 neuronas artificiales signifique que una neurona biológica sea exactamente 1.000 veces más compleja. Por último, es posible que el uso de neuronas artificiales internas conduzca a una red neuronal profunda con una sola capa. Pero probablemente requeriría muchos más datos y tiempo para que el algoritmo aprenda.